Beschleunigen Sie das schnelle Replizieren, Erfassen und Streamen von Daten aus den unterschiedlichsten heterogenen Datenbanken, Data Warehouses und Big-Data-Plattformen. So können Sie Daten einfach, sicher und effizient übertragen, ohne das operative Geschäft zu beeinträchtigen.

MUST-READ

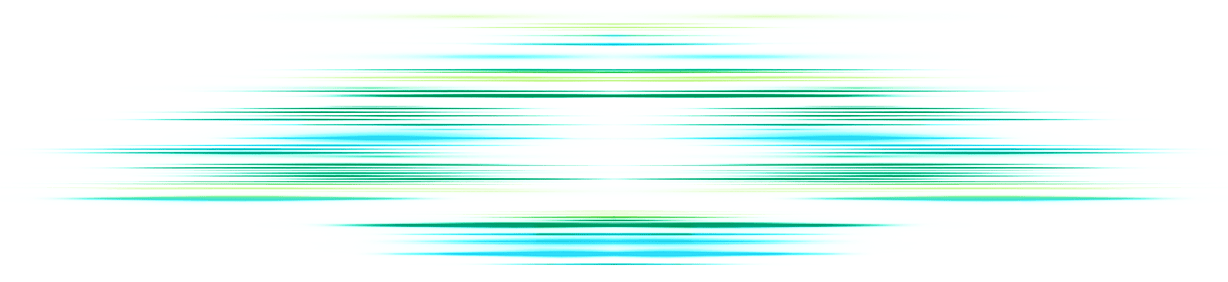

Gartner® Magic Quadrant™ for Data Integration Tools 2024

Lesen Sie, warum Qlik® im Gartner Magic Quadrant for Data Integration Tools als Leader eingestuft wurde.

Daten allgemein verfügbar machen

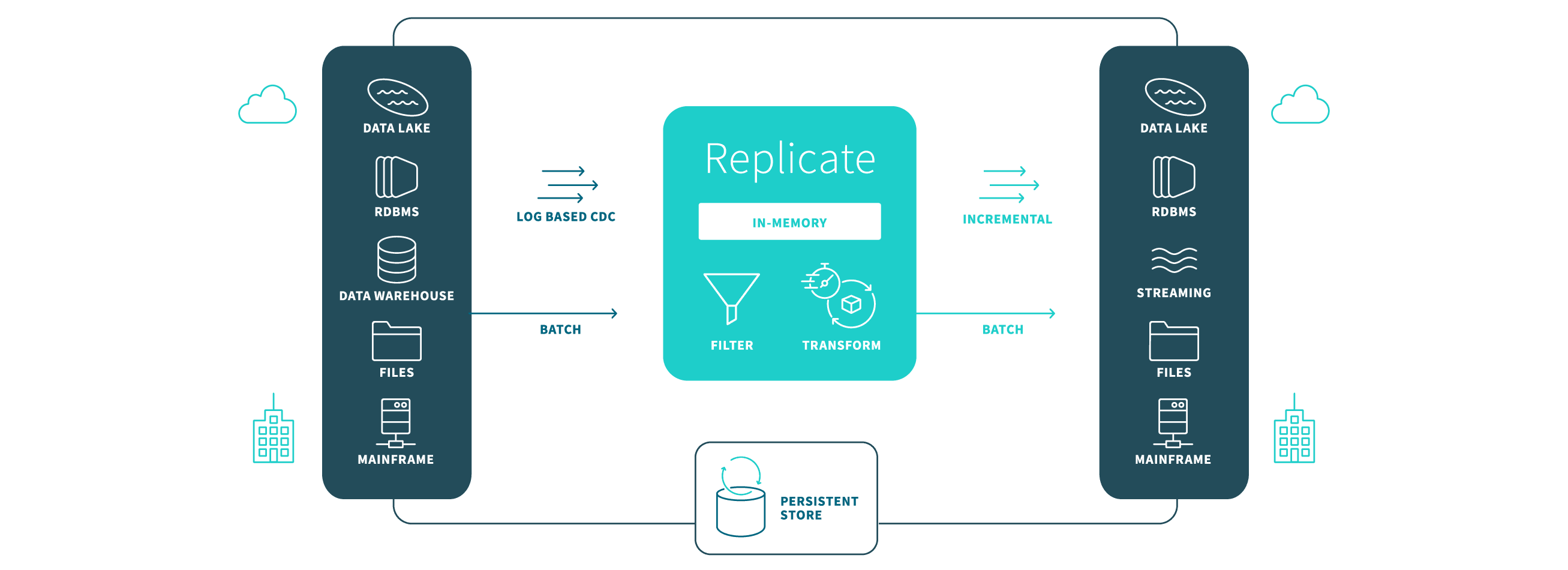

Ob On-Premises oder in der Cloud: Replizieren, synchronisieren, verteilen, konsolidieren und erfassen Sie Daten übergreifend in bzw. aus allen wichtigen Datenbanken, Data Warehouses und Hadoop. Einige Beispiele:

Ein internationaler Versicherungskonzern senkte die nächtliche Batch-Ladezeit von 6 bis 8 Stunden auf unter 10 Minuten.

Ein großes Kreditinstitut konnte 14 Millionen Änderungen an der Quelle in 30 Sekunden auf des Ziel anwenden.

Schnellere Datenintegration für Analysen

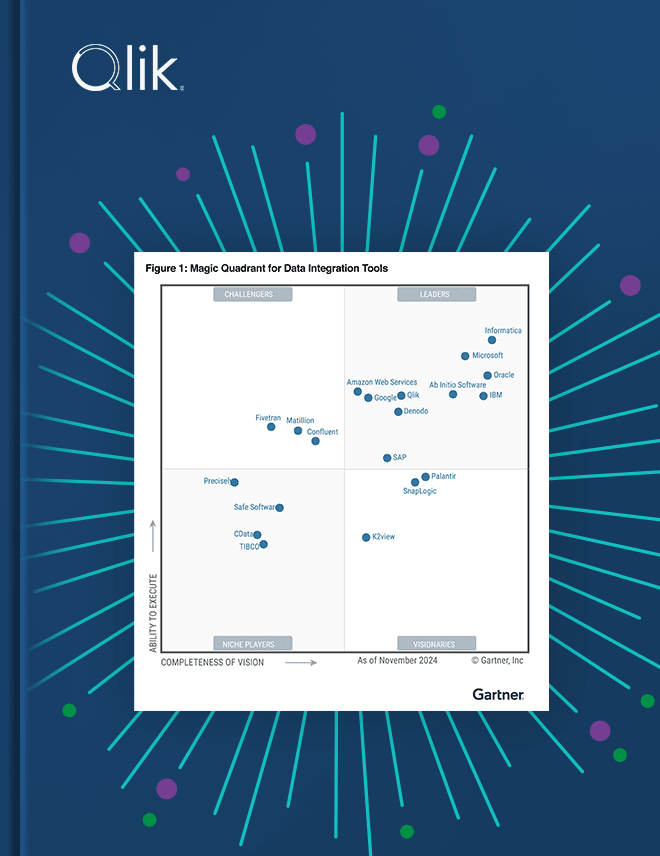

In der intuitiven grafischen Benutzeroberfläche können Sie eine Datenreplikation ohne manuellen Programmieraufwand schnell und problemlos aufsetzen.

Kinderleichtes Erfassen riesiger Datenmengen aus Tausenden von Quellen in Big-Data-Plattformen

Automatisches Generieren von Zielschemata auf Basis von Quellmetadaten

Effizientes Verarbeiten von Big-Data-Ladevorgängen mit parallelem Threading

CDC-Prozesse (Change Data Capture) nutzen und mit weniger Aufwand Echtzeitanalysen bereitstellen

Mehr Geschwindigkeit für Ihre Datenpipeline

Daten plattformübergreifend integrieren

Sie können Daten On-Premises, in der Cloud oder in hybriden Umgebungen laden, erfassen, migrieren, verteilen, konsolidieren und synchronisieren. Folgende Systeme werden unterstützt:

RDBMS: Oracle, SQL, DB2, MySQL, Sybase, PostgreSQL

Data Warehouses: Azure Synapse, Snowflake, Exadata, Teradata, IBM Netezza, Vertica, Pivotal

Cloud-Plattformen: AWS, Azure, Google Cloud

Cloud-Service-Plattformen: Databricks, Snowflake, Confluent

Streaming-Plattformen: Apache Kafka, Confluent, Azure Event Hubs, AWS Kinesis

Unternehmensanwendungen: SAP, Salesforce

Mainframe: IMS/DB, DB2 z/OS, RMS, VSAM

Eine vollständige Liste aller Konnektivitätsoptionen finden Sie in der Supportmatrix.

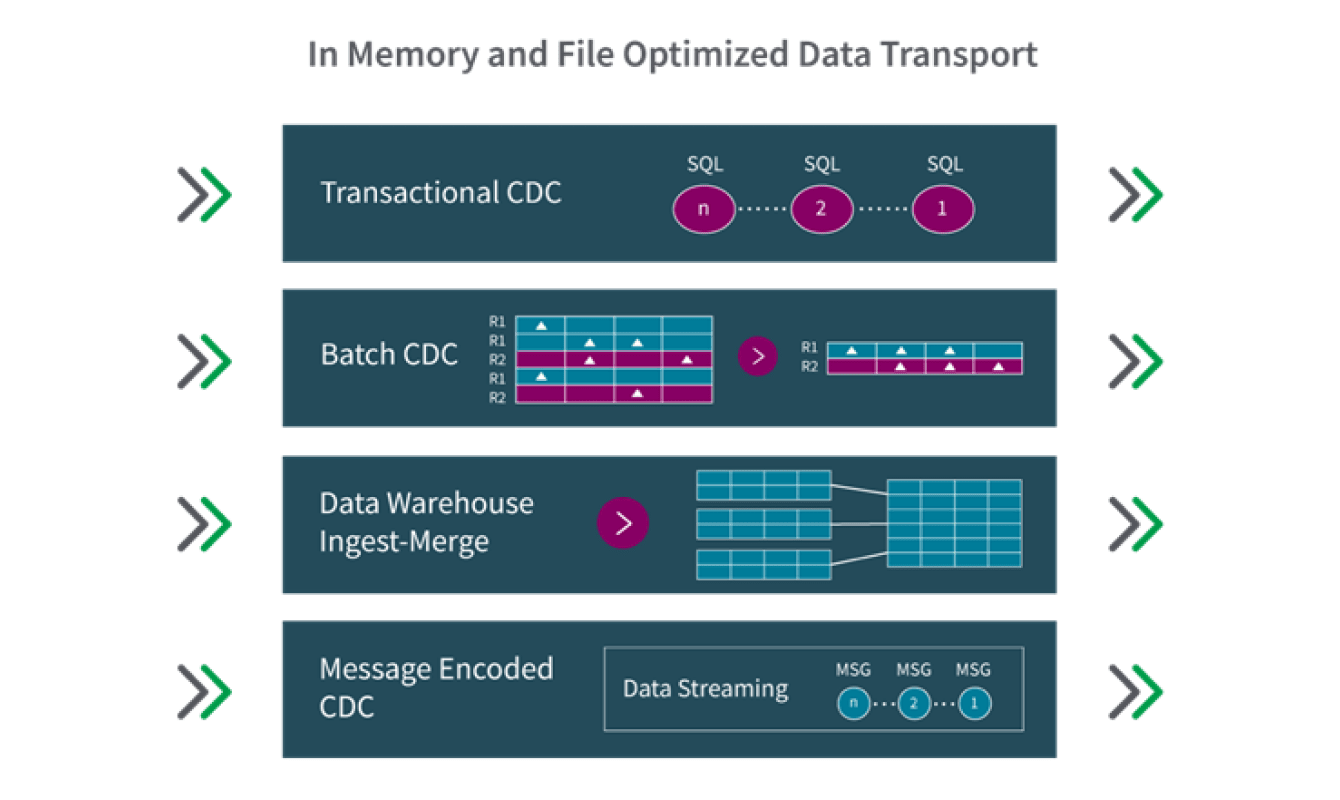

Eine vielseitige Plattform für Change Data Capture (CDC)

Ressourcenschonendes Echtzeit-CDC für viele Datenbanksysteme bietet Ihnen flexible Optionen zur Verarbeitung erfasster Datenänderungen:

Transaktionsbezogen: Wenden Sie Transaktionen in der Reihenfolge an, in der sie in die Quelle übertragen wurden und stellen Sie strikte referenzielle Integrität und niedrigste Latenz sicher.

Batch-optimiert: Gruppieren Sie Transaktionen in Batches und verbessern Sie so das Erfassen und Zusammenführen von Daten in Data Warehouses und vielen anderen On-Premises- oder Cloud-Zielen.

Data-Warehouse-optimiert: Laden Sie Daten mit nativen Performance-optimierten APIs für Snowflake®, Azure Synapse und andere EDWs, die Massively Parallel Processing (MPP) nutzen.

Nachrichtenorientiertes Daten-Streaming: Zeichnen Sie Datenänderungen auf und streamen Sie sie an Message Broker wie Apache® Kafka®.

Leistungsstark und skalierbar

Kaum eine andere Lösung unterstützt so viele Quellen und Ziele. Sie können Daten On-Premises, in der Cloud oder in hybriden Umgebungen laden, erfassen, migrieren, verteilen, konsolidieren und synchronisieren.

Hoher Durchsatz und niedrige Latenz: Übertragen Sie Daten mit Hochgeschwindigkeit innerhalb des Unternehmens oder zwischen hybriden Umgebungen und erfüllen Sie geschäftliche Anforderungen in Echtzeit.

Hohe Skalierbarkeit: Replizieren Sie Ihre Daten über Hunderte von Quellen und Zielen hinweg.

Ressourcenschonend: Profitieren Sie von der protokollbasierten Zero Footprint-Technologie, die Performance-Auswirkungen bei Datenquellen und -zielen minimiert.

Zentrale Überwachung und Steuerung: Über eine Oberfläche können Sie Datenendpunkte erstellen und Replikationsaufgaben anlegen und ausführen.

Überwachen Sie Tausende von Tasks über eine zentrale Konsole mit benutzerdefinierten Warnungen und KPIs.

Bequeme SAP-Analysen

Nutzen Sie SAP-Anwendungsdaten in Echtzeit für Big-Data-Analysen.

Flexibilität: Ob On-Premises oder in der Cloud, Ihre Datenbank, Ihr Data Warehouse oder Hadoop erhält stets die richtigen SAP-Anwendungsdaten.

Einfacher Datenzugriff: Auch komplexe SAP-Formate lassen sich problemlos erfassen und umwandeln. Exportieren Sie die Daten dann über eine intuitive, automatisierte Oberfläche, die speziell für die SAP-Umgebung entwickelt wurde.

Echtzeit-Integration: Erfassen Sie SAP-Livedaten für Echtzeitanalysen in Data Lakes oder anderen Zielen und erstellen Sie Kafka-Livenachrichten für Streaming-Analysen.

Optimierter Datenaustausch für Cloud-native Umgebungen

Für volle Hybrid-Mobilität: Übertragen Sie Daten in, aus und zwischen allen wichtigen Cloud-Plattformen und Cloud-Service-Anbietern.

Für Höchstleistungen: Komprimieren und übertragen Sie Daten effizient auf unterschiedlichen Pfaden im WAN (Wide Area Network).

Für sicheren Datentransfer: Nutzen Sie die Vorteile modernster, NSA-geprüfter Verschlüsselungsmethoden (AES-256).

Eine Cloud- und anbieterunabhängige Plattform für die Datenintegration

Sichern Sie sich ein Höchstmaß an Auswahlmöglichkeiten und Flexibilität bei der Entscheidung, wo Ihre Daten gespeichert, transformiert und analysiert werden sollen.

Qlik Cloud Data Integration: eine von Qlik verwaltete EIPaaS-Lösung (Enterprise-Integration-Platform-as-a-Service)

Qlik Data Integration: eine Client-Managed-Lösung, die On-Premises oder als VM-Image an einem Standort Ihrer Wahl installiert werden kann.